vCenter vmdir.password error is not set

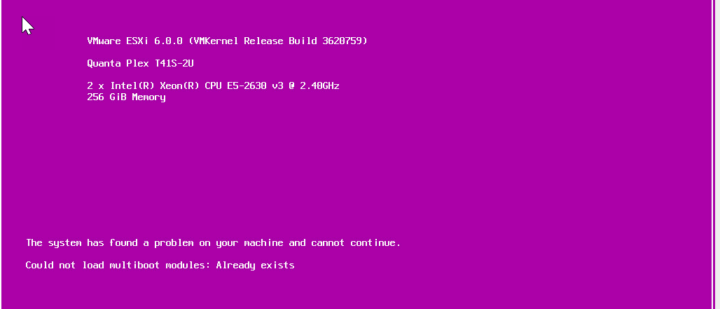

Wanneer je een vCenter Server 7.x gaat updaten en vervolgens op de volgende foutmelding “vmdir.password is not set” stuit wanneer je op de console kijkt: vmdir.password is not set; aborting installation Dit komt omdat de cap first boot service RPM niet meer bestaat in versie 7.0.2 en hoger. Door een bug in de upgrade scripts komt […]

vCenter vmdir.password error is not set Meer lezen »